Édition 73- IA générative et confidentialité : vraiment incompatibles ?

#73 Comprendre l'utilisation de ses données en matière d'IA

Si vous aimez mon contenu, cliquez sur le ❤ au-dessus et à côté de mon nom pour m’aider à remonter sur Substack ou Gmail et parce que ça me donne encore plus envie de faire mieux la prochaine fois 😊

C’est samedi, le jour d’EthicGPT ! 😊 Je suis très heureux de vous retrouver pour cette 73e édition !

Si quelqu’un vous a transféré cette édition et que le contenu vous plaît, n’hésitez pas à vous abonner et à la transférer également. Cela m’aidera beaucoup pour faire connaître mon travail 😌

Quelques liens utiles si jamais vous débarquez ici pour la première fois :

Mon site internet où je présente mon activité

Ma formation Juristes Augmentés

La présentation et les archives de cette newsletter

Prêt(e) à consacrer ces quelques minutes sur l’IA avec moi ? C’est parti 🚀

Aujourd’hui, je vais aborder quelque chose de très important : la confidentialité des données. Pour moi, c’est un peu un retour aux sources, parce que j’ai été juriste plus de 7 ans en droit numérique, avec une spécialisation en protection des données.

C’est donc quelque chose que je pense bien connaître. Or, ce sujet est partout. Et souvent, il est incompris :

Le RGPD est très mal vendu, car c’est avant tout une contrainte pour les entreprises,

La majorité de la population s’en fout de ses données sur internet,

Les enjeux sont quand même potentiellement graves.

Avec l’arrivée de ChatGPT et, plus généralement, d’une IA générative pour tous, les questions liées à la confidentialité des données sont devenues essentielles pour plein de raisons. Utiliser l’IA ? Oui. Automatiser ? Pourquoi pas. Mais comment le faire tout conservant la confidentialité de ses données, qui puis est quand on est avocat(e) avec le secret professionnel.

Qu’est-ce que la confidentialité des données ?

Le titre soulève deux concepts essentiels : les données et la confidentialité.

Quand il est question de données, je pense d'abord à celles définies par le RGPD, le fameux règlement européen visant la protection des données. Cela concerne toute information permettant d’identifier, directement ou indirectement, une personne. Cependant, cette définition devient restrictive dès lors que l’on parle d’IA générative, car elle ne s’applique qu’aux individus.

En réalité, le RGPD ne s’étend pas aux données des entreprises. Or, lors de l'utilisation de ChatGPT, les données échangées sont souvent d’ordre professionnel. Celles-ci revêtent alors une grande importance en matière de confidentialité.

La confidentialité implique que certaines informations ne doivent pas être accessibles publiquement et doivent rester privées. Il s’agit donc de protéger ces informations sensibles afin d’éviter tout accès non autorisé, comme vous tenez à ce que vos messages WhatsApp ne soient pas consultés par n’importe qui.

Ainsi, la confidentialité des données consiste à préserver les informations présentes dans les données, qu’elles soient personnelles ou professionnelles. Ce caractère confidentiel est primordial, surtout lorsqu'il est question d’IA générative.

L’utilisation des données par les IA génératives

Si vous lisez cette newsletter, c’est que l’IA générative vous intéresse et que vous avez une compréhension générale de son fonctionnement. Une IA comme ChatGPT a pour but de produire un contenu à partir d’un prompt, qui est simplement une instruction écrite. ChatGPT, par exemple, procède en prédisant la suite de mots la plus logique et cohérente. C’est un modèle prédictif.

Pour générer du contenu, les IA génératives ont été entraînées avec un immense volume de données (ex : du texte pour ChatGPT, des images pour Midjourney). Ces données proviennent soit des développeurs des outils, soit (surtout) d’internet. On voit déjà ici un premier enjeu en matière de confidentialité, sur lequel je reviendrai.

Un troisième type de données s’ajoute depuis que ChatGPT et ses concurrents sont disponibles au public : votre historique d’utilisation, si vous n’avez pas une version comme la version Team de ChatGPT. En d’autres termes, OpenAI utilise les informations issues de vos conversations pour s’entraîner et s’améliorer. C’est notamment grâce à cela que ChatGPT sait désormais qu’une vache ne pond pas d’œufs (les vrais commencent la ref' !).

Ainsi, c’est l’usage de ces données qui permet à ChatGPT de bien fonctionner. Sans cette collecte, il n’y aurait pas d’IA générative aussi efficace. Toutefois, cette collecte soulève des questions importantes quant à la confidentialité.

Ce problème touche surtout les IA génératives textuelles. Pour les IA génératives d’images, comme Midjourney, la problématique est différente : il s’agit plutôt de questions de droits d’auteur, mais c’est un autre sujet.

Quel est le problème de l’IA générative à propos de la confidentialité ?

De nombreuses questions entourent la confidentialité des données. La première concerne les données d’entraînement. On sait en partie ce qu’a utilisé OpenAI, comme Wikipedia, mais il est possible que des informations plus sensibles aient également été intégrées sans que cela soit clairement précisé. OpenAI reste en effet assez opaque à ce sujet.

Cependant, les risques liés à la confidentialité dans le cadre de l'IA générative vont bien au-delà des données récupérées sur internet. Le principal problème se situe au niveau des échanges dans les chats. À ce jour, il demeure flou de savoir qui a accès aux données de ces conversations. C’est d’ailleurs l’une des raisons pour lesquelles ChatGPT a été temporairement bloqué dans certains pays comme l’Italie, au printemps 2023, avant que des garanties soient apportées.

Les données de chat sont-elles “lues” uniquement par l’algorithme qui les utilise pour se nourrir ? Où sont-elles hébergées ? Sont-elles partagées ? Autant de questions sans réponses précises.

Officiellement, les données sont stockées dans le cloud, principalement sur des serveurs Azure de Microsoft. Parce que oui, la relation OpenAI / Microsoft est très forte, ce sont 2 partenaires et il ne faut jamais oublier cela quand vous pensez que Microsoft représente un coffre-fort.

Cela soulève aussi des enjeux juridiques pour la protection de ces données. Comme mentionné précédemment, en Europe et en Suisse avec la nLPD, le RGPD protège uniquement les données personnelles, mais pas les données professionnelles. Or, bien que l’usage de données personnelles par ChatGPT suscite de nombreuses réactions, ce sont, à mon sens, les données professionnelles qui posent le plus de difficultés.

En 2023, des entreprises comme Samsung et même Apple ont interdit temporairement l’accès à ChatGPT. D’autres l’ont interdit de manière permanente. Je me rappelle encore de cette entreprise dans le secteur du gaz, que j’ai accompagnée, qui avait formellement interdit ChatGPT… tout en déroulant le tapis rouge à Microsoft !

Néanmoins, on part du principe que si OpenAI accède à des informations sensibles, un réel problème de confidentialité se pose. Et pire encore, si ces données sont compromises (consultées par des tiers non autorisés, piratées, etc.), elles pourraient se retrouver accessibles au public, ce qui accroît encore les risques.

En conclusion, une vraie réflexion s’impose sur la confidentialité des données, et des solutions, actuelles ou à venir, existent pour y répondre.

Quelles solutions pour remédier aux problèmes de confidentialité de l’IA générative ?

Des solutions directement disponibles dans ChatGPT

Il existe 2 solutions immédiates et vraiment simples.

La première, c’est de ne pas partager des données confidentielles et sensibles sur ChatGPT 🤡 Oui, je sais, elle était facile, mais c’est bel et bien une solution ! Vous pouvez anonymiser les données en amont du prompt et dans vos documents que vous partagez C’est une vraie solution qu’il ne faut pas négliger.

La seconde, c’est d’utiliser les versions Team et Enterprise, qui garantissent que les données des chats et des assistants GPTs ne sont pas utilisées. Néanmoins, certains soulignent à juste titre qu’avec la version Team, il y a une rétention de 30 jours, sans que l’on sache réellement ce qu’OpenAI en fait.

En revanche, vous avez compris que cette option effaçait vos historiques et vous ne pouvez donc plus utiliser après ! Il faut aussi faire confiance en OpenAI sur la réelle suppression des données (on va dire que c’est OK).

Avoir ChatGPT en local

En local, cela signifie que les données restent sur votre serveur et ne vont pas sur ceux d’OpenAI par exemple. C’est un vrai modèle pour préserver les données les plus confidentielles, car personne d’autre que vous y accès. Pour moi, c’est le meilleur moyen d’utiliser toute la puissance de l’IA générative sans avoir peur pour ses données.

Cependant, cela demande des connaissances et, surtout, vous utilisez toujours l’API d’OpenAI, qui a les mêmes conditions pour les données que la version Team.

Tester Claude d’Anthropic

À ce jour, Claude reste la seule IA générative de texte capable de rivaliser en qualité avec les LLMs d’OpenAI. Or, Anthropic affirme que, sauf exceptions, nos données ne sont pas utilisées pour entraîner leurs modèles, peu importe la version utilisée.

We will not use your Inputs or Outputs to train our models, unless: (1) your conversations are flagged for Trust & Safety review (in which case we may use or analyze them to improve our ability to detect and enforce our Usage Policy, including training models for use by our Trust and Safety team, consistent with Anthropic’s safety mission), or (2) you’ve explicitly reported the materials to us (for example via our feedback mechanisms), or (3) by otherwise explicitly opting in to training.Quelles perspectives pour la confidentialité des données dans l’IA générative ?

Les problèmes liés à la confidentialité des données sont loin d’être résolus. Et si l’IA générative continue à s’améliorer et à être utilisée par un nombre toujours plus grand de personnes, ce problème va même s’amplifier.

Or, si ChatGPT continue à être un peu seul dans les IA génératives de texte, cela va donner un pouvoir bien trop fort à OpenAI, mais aussi à Microsoft. Pour une IA éthique, il faut bien sûr plus de concurrents, mais aussi de véritables solutions pour préserver la confidentialité des données. Claude essaie de se frayer un chemin, c’est très difficile.

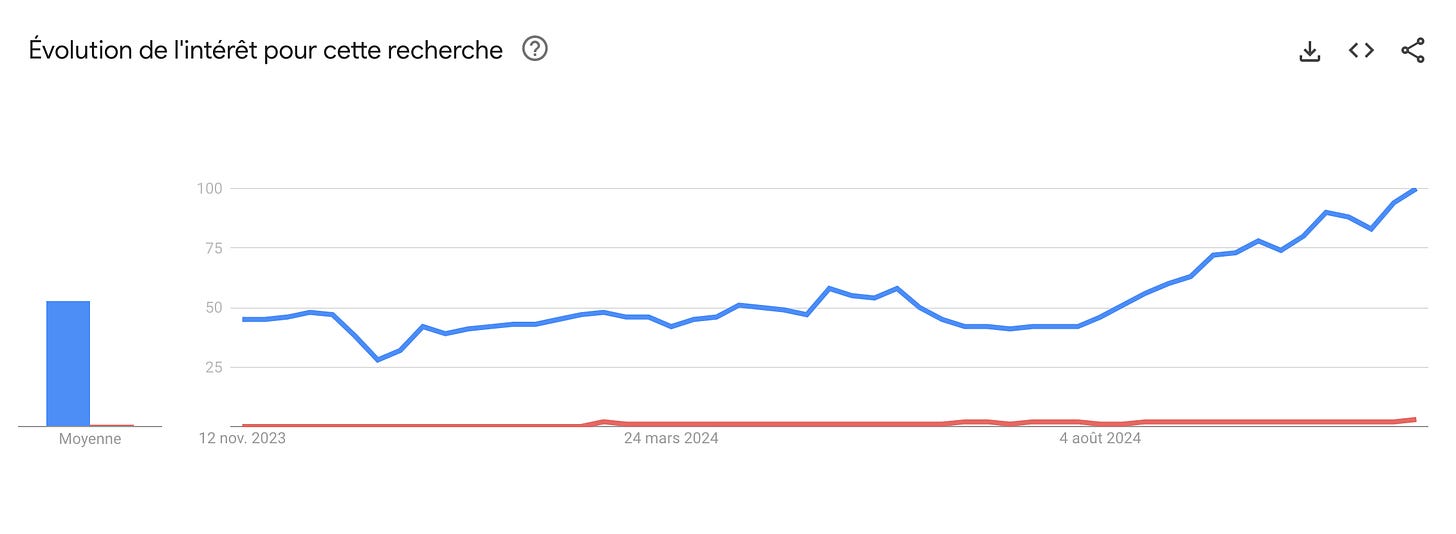

Quand on voit cette Google trend, c’est assez difficile à imaginer un changement rapide.

Pour moi, la question de la confidentialité va devenir essentielle et la situation actuelle ne va pas durer pour que l’IA s’impose chez certaines professions. Je pense notamment aux avocats et au secret professionnel. Pour l’instant, on utilise gentiment ChatGPT, on veut utiliser Microsoft parce qu’on lui fait (trop) confiance et on s’aperçoit que Copilot reste mauvais.

Je pense que, petit à petit, les modèles open source vont s’imposer pour des professions soumises au secret professionnel. Mais il faudra alors que les modèles s’améliorent grandement et que l’on puisse construire des automatisations avec.

Voilà, c’est tout pour aujourd’hui, à la semaine prochaine ! 😀

Merci pour cette info sur Claude, notamment... Maintenant, je me demande quel est le niveau de qualité des modèles open source existants ? On est encore loin de ChatGPT ?