Édition 58 - Une brève histoire de l'intelligence artificielle

#58 D'Alan Turing à la fin de l'Hiver de l'IA (Partie 1)

Si vous aimez mon contenu, cliquez sur le ❤ au-dessus et à côté de mon nom pour m’aider à remonter sur Substack ou Gmail et parce que ça me donne encore plus envie de faire mieux la prochaine fois 😊

C’est vendredi, le jour d’EthicGPT ! 😊 Je suis très heureux de vous retrouver pour cette 58e édition !

Si quelqu’un vous a transféré cette édition et que le contenu vous plaît, n’hésitez pas à vous abonner et à la transférer également. Cela m’aidera beaucoup pour faire connaître mon travail 😌

Quelques liens utiles si jamais vous débarquez ici pour la première fois :

Mon site internet où je présente mon activité

Vous souhaitez sponsoriser cette newsletter ? C’est par ici

Mes formations Juristes Augmentés et Découvrir Mistral AI

La présentation et les archives de cette newsletter

Prêt(e) à consacrer ces quelques sur l’IA avec moi ? C’est parti 🚀

L’été est objectivement une période plus complexe pour bosser et écrire cette newsletter. En plus, avec les JO au milieu, c’est encore pire 😅 J’ai donc sauté l’édition de la semaine dernière pour mieux revenir ! Et le programme du mois d’août est déjà ficelé.

Cette semaine et la suivante, j’ai décidé de vous partager une brève histoire de l’IA pour que vous sachiez d’où l’on vient. Cela me paraît important pour bien appréhender l’IA générative d’aujourd’hui. Et c’est tellement essentiel que je vais le faire en 2 parties !

Le 23 août, je vous ferai un retour complet sur le Voice Mode d’OpenAI. En espérant que j’y ai accès d’ici-là. Enfin, le 30 août, une édition qui sera peut-être très attendue : une présentation détaillée et complète de Copilot de Microsoft.

Donc aujourd’hui, parlons des débuts de l’IA jusqu’à ce qu’on a appelé l’Hiver de l’IA.

Les débuts de l’IA et la vision du génie Alan Turing

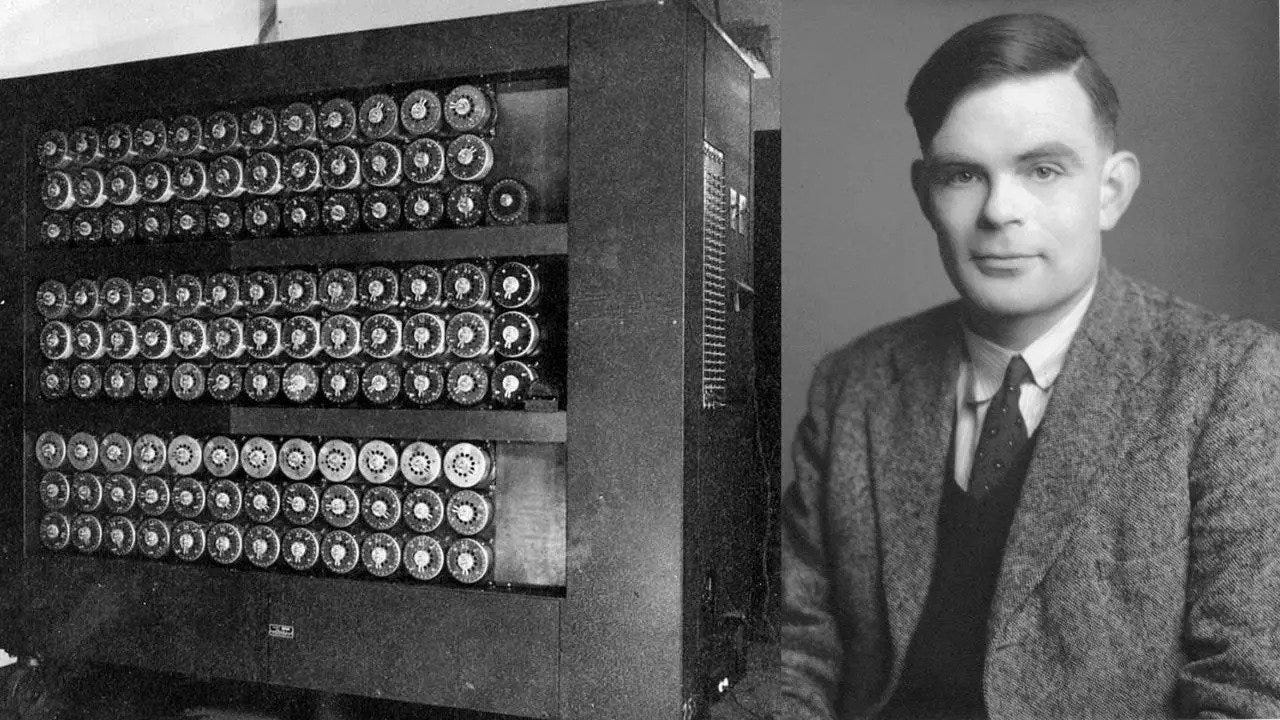

On dit que l’histoire de l'intelligence artificielle commence avec Alan Turing. C’est une simplification, mais c’est assez vrai aussi. Génie britannique de la période “pré-informatique”, Turing introduit le concept de la machine universelle en 1936, une machine capable de simuler n'importe quelle machine de calcul. C'est la naissance de la machine de Turing, la base théorique de nos ordinateurs modernes.

C’est ce même Alan Turing qui déchiffre Enigma pendant la Seconde Guerre Mondiale. Enigma était un moyen de communication des Nazis… grâce à la machine de Turing !

En 1950, Turing publie "Computing Machinery and Intelligence", se posant la question de savoir si les machines peuvent penser. Il propose le test de Turing, une expérience simple pour évaluer l'intelligence d'une machine. L'idée ? Si une machine peut converser de manière indiscernable d'un humain, elle pourrait être considérée comme intelligente. Ce concept continue de stimuler les débats aujourd'hui, même si l’on considère qu’il n’est plus valide. Une machine peut converser comme un humain sans possibilité de penser.

Les années 1940 et 1950 voient aussi les premières réalisations concrètes. Warren McCulloch et Walter Pitts modélisent les neurones artificiels en 1943, ouvrant la voie aux réseaux de neurones. Claude Shannon, en 1950, publie un article fondateur sur la programmation des ordinateurs pour jouer aux échecs. Les premières expérimentations en informatique cognitive et en modélisation neuronale émergent, posant les fondements de l'IA.

Le programme Logic Theorist de Newell et Simon en 1956 est l'une des premières machines à démontrer des théorèmes mathématiques. L'ordinateur IBM 701, avec ses applications en IA, symbolise cette période d'innovations. Ces pionniers et leurs travaux ont jeté les bases solides sur lesquelles repose toute la recherche en IA.

Ainsi, les débuts de l'IA sont marqués par des avancées théoriques et pratiques, ancrées dans la vision audacieuse de Turing et ses contemporains. Une époque où la science-fiction commence à devenir réalité.

Les conférences de Dartmouth et la naissance officielle de l'IA

La naissance officielle de l’expression Intelligence Artificielle date de la conférence de Dartmouth en 1956. John McCarthy, Marvin Minsky, Nathaniel Rochester et Claude Shannon organisent cet événement historique avec un objectif ambitieux : définir et lancer le champ de l'IA. Cette conférence est considérée comme le point de départ de l'IA en tant que discipline académique. On y rêve alors de machines capables de résoudre des problèmes aussi bien que les humains.

À la suite de cette conférence, plusieurs laboratoires et centres de recherche dédiés à l'IA voient le jour. Le MIT fonde son propre laboratoire d'intelligence artificielle sous la direction de Minsky, un des participants de Dartmouth. À Stanford, John McCarthy, autre figure clé de Dartmouth, crée un autre centre influent de recherche en IA.

Les premières réalisations concrètes ne se font pas attendre. John McCarthy développe le langage de programmation LISP en 1958, spécialement conçu pour la recherche en IA et encore utilisé aujourd'hui.

Le programme General Problem Solver (GPS) de Newell et Simon voit le jour et devient l'un des premiers programmes capables de résoudre une large gamme de problèmes de manière logique. Les premiers systèmes experts, comme DENDRAL en chimie et MYCIN en médecine, démontrent que l'IA peut surpasser les experts humains dans des domaines spécifiques.

Ainsi, la conférence de Dartmouth marque le début d'une ère de découvertes et de développements rapides, posant les fondations d'une discipline qui transformera profondément notre monde. Les visions de Turing prennent alors une forme concrète, propulsant l'IA dans une nouvelle dimension.

Une vision optimiste dans les années 1960 et début 1970…

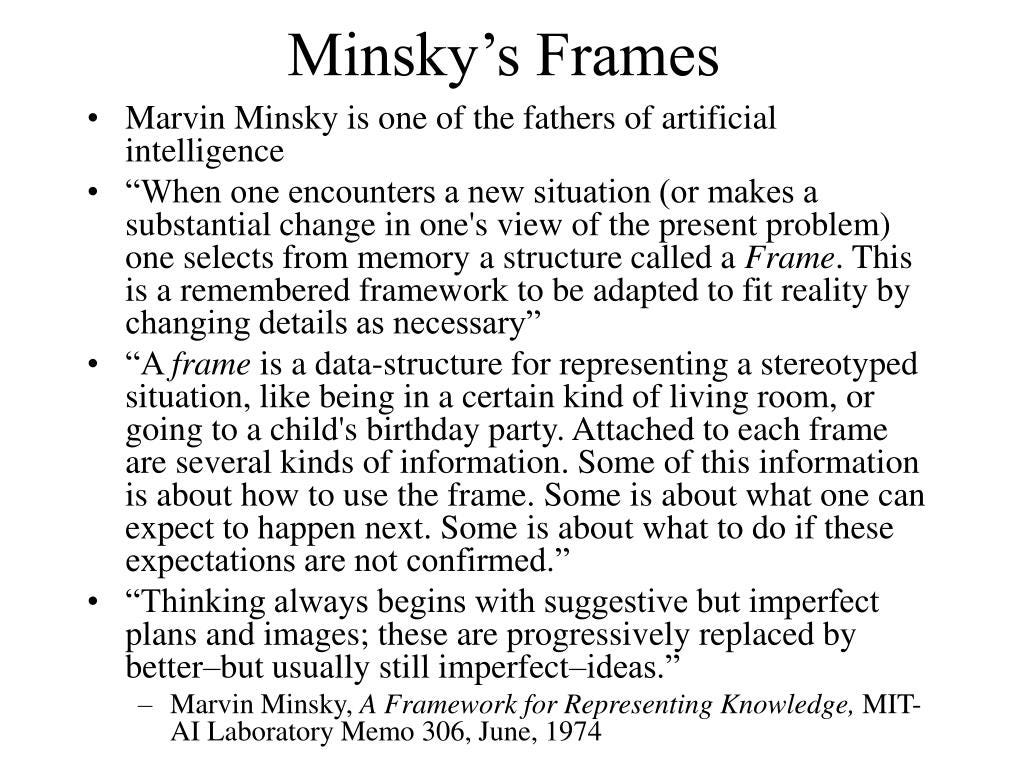

Les années 60 et 70 voient l'intelligence artificielle franchir de nouvelles étapes importantes. Les chercheurs se concentrent sur les systèmes symboliques, fondés sur la manipulation de symboles pour représenter la connaissance et résoudre des problèmes. Marvin Minsky, un des pionniers de l'IA, développe le concept de cadres (frames) et les réseaux sémantiques, structures de données essentielles pour la compréhension du langage naturel et la modélisation des connaissances.

Parallèlement, les systèmes experts connaissent un essor considérable, comme je l’ai déjà mentionné avec DENDRAL et MYCIN. Ces systèmes montrent que l'IA peut fournir une expertise précieuse dans des domaines spécialisés, en analysant des données et en formulant des hypothèses de manière rapide et précise.

Cependant, cette période n'est pas sans défis. Les limitations des systèmes symboliques deviennent évidentes, notamment l'explosion combinatoire – le phénomène où le nombre de possibilités à explorer croît de manière exponentielle, rendant la résolution de problèmes très complexe et inefficace. Hubert Dreyfus, un philosophe critique de l'IA, argumente que les ordinateurs ne pourront jamais reproduire la pensée humaine en se fondant uniquement sur des symboles et des règles. C’est notamment dans son livre What Computers Can’t Do qu’il explique sa théorie.

Les questions éthiques commencent également à émerger, les chercheurs et le public se demandant quelles pourraient être les conséquences de l'IA sur la société. Ces réflexions sont cruciales pour orienter les futures recherches et applications de l'IA, posant les fondements d'un débat qui continue encore aujourd'hui.

En somme, les années 60 et 70 sont marquées par des avancées significatives et des défis conceptuels, techniques et éthiques. Ces décennies posent les jalons pour les développements futurs de l'IA, tout en soulevant des questions fondamentales sur ses possibilités et ses limites. Et on arrive alors à l’Hiver de l’IA.

… avant la réalité d’un Hiver de l’IA jusqu’à la fin des années 1980

C’est quoi ce fameux hiver ? C’est une période marquée par le désenchantement et la réduction drastique des financements pour la recherche en intelligence artificielle. En gros, les promesses faites par les pionniers de l'IA ne se concrétisent pas aussi rapidement que prévu, entraînant une perte de confiance des investisseurs et des gouvernements.

Une des causes de cet hiver est l'échec de la traduction automatique à répondre aux attentes. Les premiers systèmes de traduction, comme ceux financés par l'‘agence américaine DARPA (Defense Advanced Research Projects Agency), produisent des résultats médiocres. Les limitations linguistiques et la complexité de la langue humaine montrent rapidement les insuffisances des approches symboliques et des algorithmes simples utilisés à l'époque.

Le rapport Lighthill de 1972, commandé par le gouvernement britannique, critique sévèrement l'état de la recherche en IA.

Ce rapport met en lumière les échecs des systèmes de traduction automatique et des programmes de résolution de problèmes, soulignant les limites des systèmes symboliques et l'incapacité des machines à gérer des situations du monde réel. Et le constat est assez “violent” :

The most notorious disappointments, however, have appeared in the area of machine translation, where enormous sums have been spent with very little useful result, as a careful review by the US National Academy of Sciences concluded in 1966; a conclusion not shaken by any subsequent developmentsLes conclusions du rapport conduisent à une réduction significative des financements pour l'IA au Royaume-Uni et influencent les décisions de financement dans d'autres pays.

Les conséquences sont sévères : les financements publics et privés pour l'IA diminuent considérablement. La DARPA, qui avait été un soutien majeur, réduit également ses investissements dans l'IA, réorientant ses fonds vers des projets plus prometteurs mais très spécifiques (coucou les échecs, on en parle la semaine prochaine). De nombreux laboratoires et projets sont abandonnés ou redirigés vers d'autres domaines. L'intérêt académique pour l'IA décline et les chercheurs se tournent vers d'autres champs de recherche. Cette période de refroidissement est marquée par un ralentissement des publications et des avancées majeures en IA.

Cependant, malgré cette période difficile, certaines initiatives survivent et jettent les fondations de la “renaissance” future de l'IA. Les travaux sur les réseaux neuronaux artificiels, bien que largement ignorés à l'époque, continuent en arrière-plan. La méthode de rétropropagation (backpropagation), redécouverte dans les années 80, devient un outil crucial pour l'apprentissage des réseaux de neurones. De plus, des développements en logique floue et en systèmes multi-agents maintiennent un intérêt pour des approches alternatives à l'IA traditionnelle.

Conclusion sur cette première partie

Les débuts de l'IA ont été marqués par des avancées théoriques et pratiques majeures, ancrées dans la vision de pionniers comme Alan Turing.

Cependant, des défis techniques et des attentes non satisfaites ont conduit à l'Hiver de l'IA, période qui aurait pu causer sa fin. Malgré cela, certaines initiatives ont survécu.

Dans la prochaine édition, je vais explorer cette renaissance de l'IA à partir des années 90, une époque où la science-fiction commence à devenir réalité. Parce que comprendre le passé nous aide à anticiper l'avenir de l'IA.

Place à la seconde partie la semaine prochaine ! 😁